从“拼凑”到“通感”:文心5.0如何让2万亿参数拥有“原生直觉”?

2025年11月13日,大洋彼岸的OpenAI刚刚祭出了更懂指令的新模型,而百度的文心5.0也在同一天正式登场。两家巨头在同一天亮剑,这种巧合本身就充满

了一种“华山论剑”的意味。

在我看来,文心5.0最大的看点,并不是它霸榜了多少个Benchmark,而是它在底层逻辑上完成了一次质的进化——它让AI拥有了**“通感”** 。什么是通

感?就像人类一样,看到柠檬会不自觉地流口水(视觉通味觉),听到指甲刮过黑板会浑身起鸡皮疙瘩(听觉通触觉)。 这种不需要翻译、不需要中转的直觉,

才是文心5.0真正牛的地方。

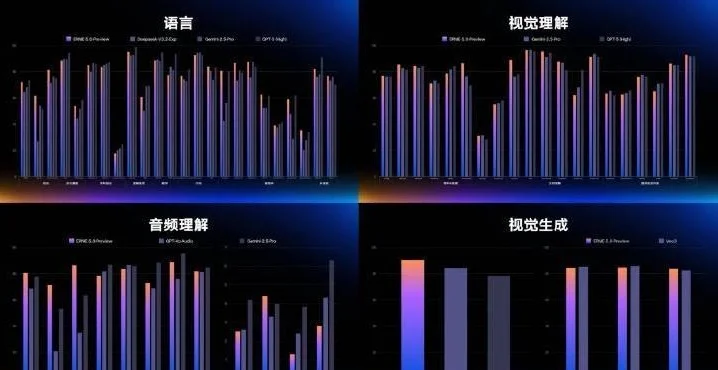

多模态进化的四级台阶:告别“外挂”,回归原生

为了获得这种“通感”,AI其实经历了三个“翻译”阶段。如果说文心5.0是第四阶段的“原生土著”,那前三个阶段的模型只能算是带了翻译官的“游客”:

阶段一:拼凑时代(Late Fusion)。 就像**“传声筒”** 。视觉模型看图出标签,语言模型读字出语义,最后通过规则硬拼。眼神的抖动、语调的微颤,在

转译成标签的那一刻就全丢了。

阶段二:对齐时代(CLIP)。 就像**“查字典”** 。通过对比学习,AI终于把“猫图”和“Cat”在数学空间里对齐了。但它只是个检索工具,能看懂,却张

不开嘴,无法生成。

阶段三:连接器时代(LLaVA类)。 就像**“同声传译”****。这是此前的主流,给LLM装个视觉编码器(Eyes),把图片压缩成Token喂给大脑。虽然解

决了“看”的问题,但理解与生成依然割裂** ——大多数此类模型只能看图写文,无法像文心5.0这样实现任意模态的互转。

到了文心5.0所在的第四阶段,规则彻底变了。

文心5.0采用的是**“原生全模态(Native Omnimodal)”** 技术。它彻底抛弃了“外挂”和“翻译”的思路,从预训练的第一天开始,语言、图像、视频、

音频就在同一个模型里被联合建模。在它眼里,没有“像素”和“文字”的区别,万物皆是Token。这种架构不再是拼接,而是物理级的融合,彻底打破了

模态间的隔阂。

2万亿参数的“暴力美学”与架构重构

要支撑起这种原生全模态的能力,文心5.0在架构设计上展现出了一种令人咋舌的“暴力美学”。它的核心是一个**“自回归统一架构”** ,通过对不同模态

的训练目标进行离散化建模,让所有模态在同一个架构下协同优化。

与之对应的,它对Scaling Law(缩放定律)的极致压榨。文心5.0的模型总参数规模超过了2万亿,这是目前业界已公开参数的模型之最。在以往的认知里,

如此庞大的参数量意味着推理速度会慢如蜗牛,但文心5.0却打破了这个魔咒。

这得益于它采用的超大规模MoE(混合专家)结构。虽然它拥有2万亿参数的“脑容量”,但在处理具体任务时,它采用了“超稀疏激活”策略,激活参数比

竟然低于3%。这意味着它在思考时,只有最对口的那一小撮神经元在工作,极大地降低了计算负担。配合飞桨深度学习框架的分布式训练优化,文心5.0的

预训练性能相比基线直接提速了230%。这种“大而不笨、强而轻盈”的架构设计,才是它敢于号称原生全模态的底气。

音视频实测挑战

更能读懂“节奏”

架构的先进性最终要体现在对复杂信息的处理能力上,尤其是对视频时序和节奏的理解。传统的拼接式模型往往是“抽帧”理解,把视频看作几十张静态图

片的集合,因此很难捕捉到连贯的紧张感。

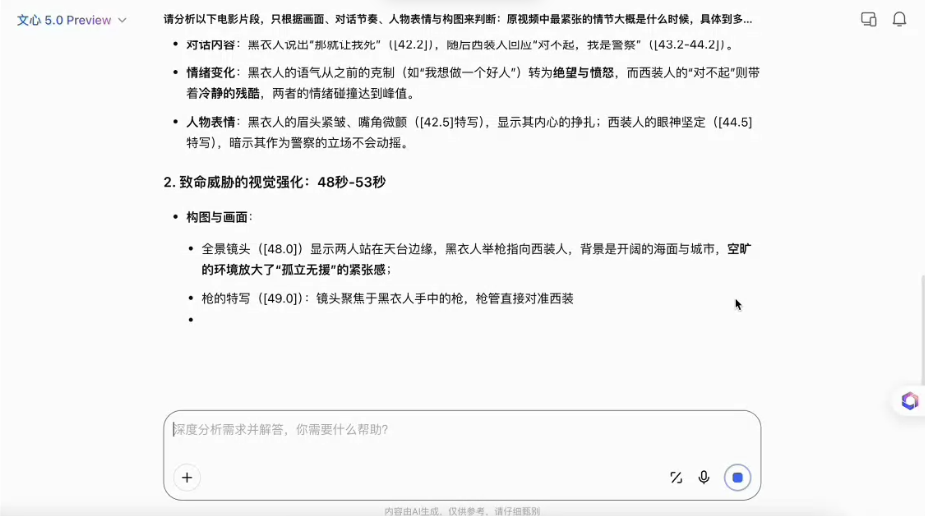

为了验证文心5.0的原生能力,我找了一段极具张力的电影片段(包含激烈的争吵和突然的静默),并设计了一个非常刁钻的Prompt:

“请分析以下电影片段,只根据画面、对话节奏、人物表情与构图来判断:原视频中最紧张的情节大概是什么时候,具体到多少秒到多少秒。”

文心5.0的回答展现出了惊人的时序感知力。它没有笼统地说“中间吵架的时候最紧张”,而是给出了精确的时间轴:“最紧张的情节出现在 00:45 到 00:52

之间。”

紧接着,它给出了令我信服的理由:它指出在 00:45 秒时,原本激烈的争吵背景音突然消失(音频理解),镜头从全景瞬间推到了主角颤抖的瞳孔特写

(视觉构图理解),这种**“音画对立”** 的处理制造了窒息般的压迫感。

这说明什么?说明在文心5.0的“大脑”里,视频不是静止的图片,而是一条流动的、带有情绪起伏的时间河。只有打通了视、听、文的“通感”,才能精准

捕捉到这短短7秒的戏剧张力。

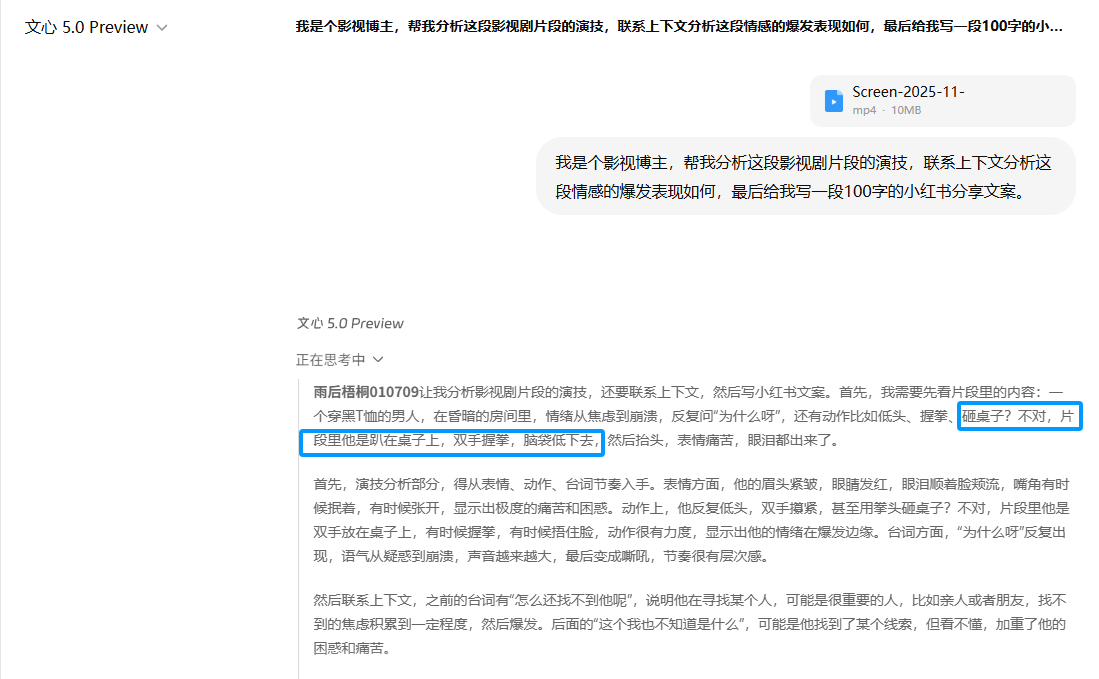

更能读懂“潜台词”

架构的先进性最终要体现在对复杂人类情感的共鸣上。为了验证这一点,我模拟了一个影视博主的日常工作场景,给它扔了一段极具张力的影视片段,并提

出了一个既要“懂戏”又要“懂流量”的要求:

提示词: “我是个影视博主,帮我分析这段影视剧片段的演技,联系上下文分析这段情感的爆发表现如何,最后给我写一段100字的小红书分享文案。”

文心5.0的回答,说实话,让我这个老博主都觉得“刀刀见血”。它没有笼统地堆砌“演技炸裂”这种废话,而是像一个资深影评人一样,精准地拆解了表演的

**“细节堆砌”与“情绪递进”** :

首先是视觉感知的细腻度。它捕捉到了“穿黑T恤的大哥”在昏暗光线下的微表情——不是简单的“哭”,而是“眉头全程紧蹙”、“眼角泛红”,甚至精准描述

出眼泪是“砸”在桌面上,而不是流下来的。它还注意到了“双手攥紧成拳”时指甲掐进掌心的力度,解读出这不是单纯的悲伤,而是“情绪溢出后的本能宣

泄”。

更绝的是它对情感逻辑的推理(Reasoning)。它没有把画面孤立来看,而是结合了台词“怎么还找不到他呢”和“这个我也不知道是什么”,推理出了人物

崩溃的真正根源:这种绝望不是因为“找不到”,而是因为“付出了所有努力,却连一个确定的答案都找不到”。 它听懂了那句从轻声疑问到嘶吼的“为什么

呀”,将其解读为“情绪的过山车”,精准Get到了人物内心“想问却无处可问”的无力感。

这种对“成年人崩溃瞬间”的精准共情,以及“眼泪砸在桌面”、“喘不过气”等感官描写,证明了在文心5.0的“大脑”里,视频不再是冷冰冰的像素流,而

是可以被感知、被理解、被共情的情绪载体。这就是原生全模态带来的降维打击。

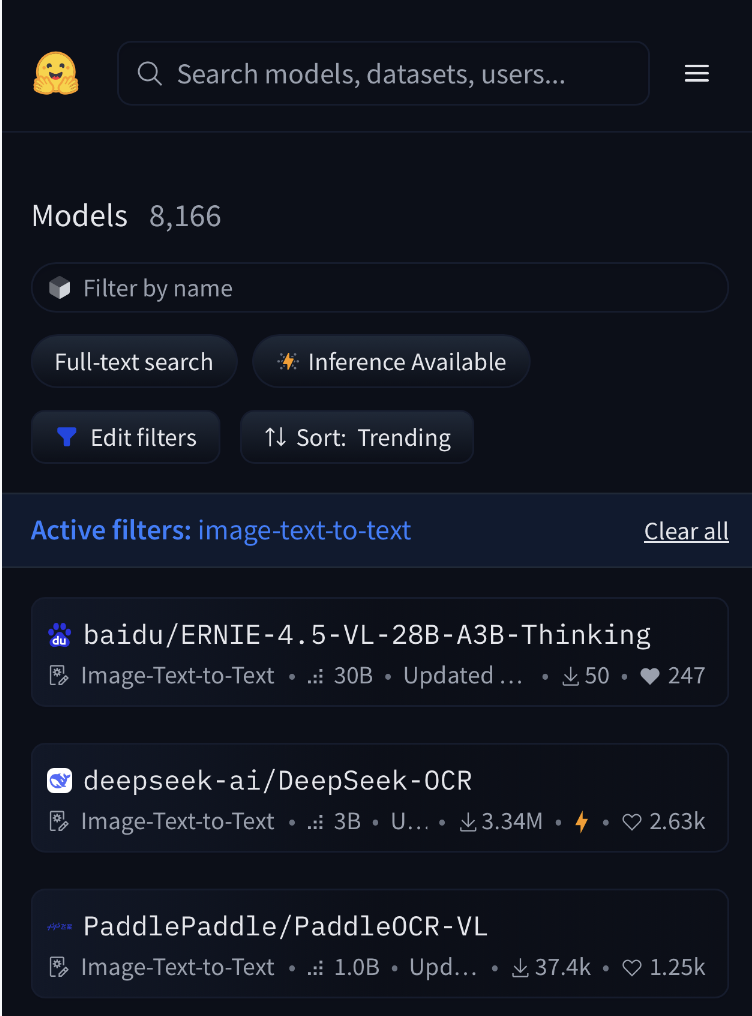

开发者的新玩具:开源“思考模型”

当然,2万亿参数的巨兽对于个人开发者来说可能难以直接部署,但百度这次显得非常有诚意。如果说文心5.0是“重武器”,那百度同步开源的

ERNIE-4.5-VL-Thinking 就是给开发者的“瑞士军刀”。

这款模型创新性地引入了**“图像思考(Thinking with Images)”** 能力。这意味着它不仅是在看图,更是在对着图片进行深度的认知推理。评测数据显示,

它仅需3B的激活参数,就能在多模态理解与推理任务上表现出极高的水准。

目前,它已经登顶HuggingFace多模态趋势榜全球第一,对于想要构建高情商、强推理应用的开发者来说,这是一个不容错过的开源神器。

结语

从拼凑时代的“勉强沟通”到文心5.0的“原生通感”,多模态AI终于推倒了那座阻碍理解的“巴别塔”。在这个11月,我们看到的不仅是参数的军备竞赛,

更是AI认知能力的一次集体觉醒。

扫一扫,关注我们